2.03. Прокси-серверы

Прокси-серверы

Что такое прокси-сервер?

Часто в процессе работы с сетями сталкивается такое понятие как «прокси».

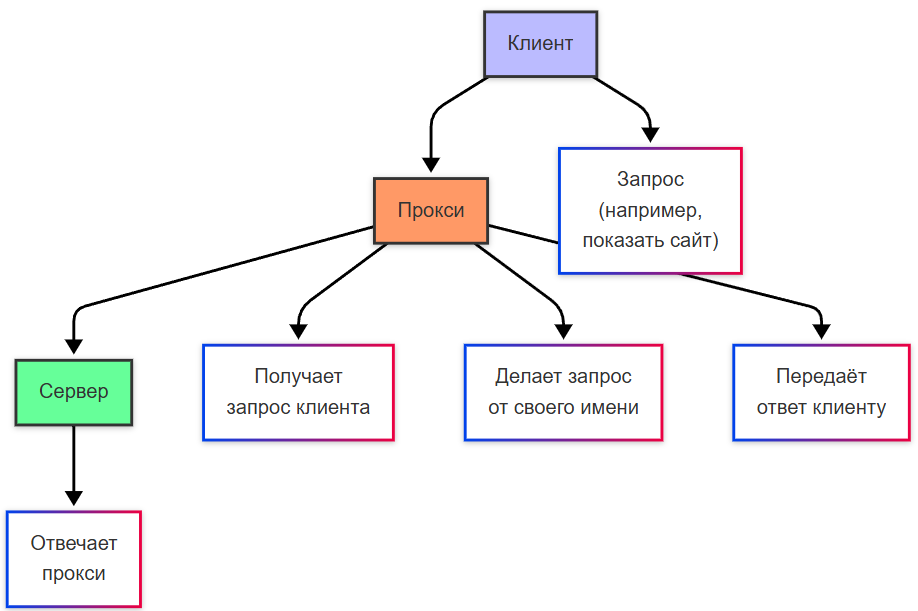

Прокси (посредник) – это промежуточный сервер между пользователем и интернетом/другим сервером. То есть, связь будет «клиент-прокси-сервер». Прокси работает так:

- клиент подключается к прокси;

- прокси получает запрос (показать сайт);

- прокси делает запрос от своего имени (может и изменить имя);

- сервер отвечает прокси;

- прокси передаёт ответ клиенту.

★ Прокси – базовая технология для:

- анонимизации (скрытия реального IP пользователя, словно «сделка через агента»);

- кеширования (ускорения загрузки сайтов за счёт работы через посредника);

- фильтрации трафика (прокси может блокировать соцсети в офисе, к примеру);

- балансировки (распределения нагрузки на сервера, «принимая на себя удар»);

- безопасности (защита от DDoS, сокрытие структуры сети).

Именно поэтому вы можете встретить на просторах интернета проверку капчи или переадресации – так и работает прокси-сервер.

Прокси-сервер — это программно-аппаратный компонент, расположенный на маршруте сетевого взаимодействия между клиентским приложением и целевым сервером, выполняющий функции посредника в обмене данными. Прокси принимает входящие запросы от клиентов, обрабатывает их в соответствии с заданной политикой и перенаправляет на целевой ресурс, после чего возвращает ответ клиенту. При этом клиент взаимодействует непосредственно с прокси, а не с конечным сервером; конечный сервер, в свою очередь, может воспринимать прокси как источник запроса — в зависимости от конфигурации.

Прокси-сервер отличается от шлюза тем, что шлюз преобразует протоколы или модели взаимодействия (например, HTTP в gRPC, SMTP в XMPP), тогда как прокси сохраняет семантику исходного протокола и передаёт запросы в том же формате, в каком они были получены. Прокси не изменяет логику прикладного взаимодействия; он лишь управляет потоком этого взаимодействия.

Прокси-сервер также отличается от реверс-прокси. Прямой прокси (forward proxy) расположен со стороны клиента и управляет исходящим трафиком: клиент осознанно конфигурирует соединение через него. Реверс-прокси (reverse proxy) расположен со стороны сервера и управляет входящим трафиком: клиент направляет запросы напрямую на адрес реверс-прокси, не зная о его посреднической роли, а реверс-прокси распределяет нагрузку между внутренними серверами.

Основные функциональные роли прокси-серверов включают маршрутизацию, фильтрацию, кэширование и анонимизацию. Маршрутизация означает выбор направления передачи запроса — например, в зависимости от домена, порта или содержимого заголовков. Фильтрация реализует политики безопасности и соответствия, применяя правила к адресам, типам контента или сигнатурам. Кэширование позволяет сохранять копии ответов на часто запрашиваемые ресурсы и выдавать их без обращения к исходному серверу — это снижает задержки и нагрузку на внешние каналы связи. Анонимизация возникает как побочный эффект скрытия исходного IP-адреса клиента при прохождении запроса через прокси; это не является встроенной целью большинства корпоративных решений, но наблюдается при определённых конфигурациях.

Классификация прокси-серверов

Прокси-серверы классифицируются по нескольким независимым критериям: направлению трафика, уровню сетевой модели OSI, в котором происходит обработка, и степени раскрытия информации о клиенте.

По направлению трафика

Прямой прокси (forward proxy) функционирует как точка выхода клиента в сеть. Все запросы от внутренних клиентов направляются через него во внешнюю среду — в интернет или во внешний сегмент корпоративной сети. Такая архитектура позволяет централизованно управлять доступом: разрешать или запрещать соединения, регистрировать активность, внедрять проверки безопасности. Прямой прокси часто используется в корпоративных сетях, образовательных учреждениях, публичных точках доступа.

Реверс-прокси (reverse proxy) функционирует как точка входа для внешних клиентов в защищённую зону. Внешние запросы поступают на адрес реверс-прокси, который перенаправляет их внутренним серверам, скрывая их реальные адреса и топологию. Реверс-прокси выполняет балансировку нагрузки, терминацию TLS-соединений, сжатие данных, ограничение частоты запросов и защиту от атак типа DDoS. Типичные реализации — Nginx, HAProxy, Traefik.

По уровню взаимодействия

Прокси четвёртого уровня (L4, транспортный уровень) работает с потоками данных на уровне TCP или UDP. Он устанавливает соединение с клиентом, создаёт параллельное соединение с целевым сервером и пересылает байты без анализа прикладного содержимого. Такой прокси не зависит от конкретного прикладного протокола — он одинаково эффективно передаёт HTTP, FTP, SMTP или произвольные бинарные потоки. Протокол SOCKS (особенно версия 5) является стандартом для L4-проксирования. Преимущество — низкая вычислительная нагрузка и универсальность. Недостаток — невозможность инспекции или модификации прикладных данных.

Прокси седьмого уровня (L7, прикладной уровень) работает с семантикой конкретных протоколов — чаще всего HTTP/HTTPS. Он разбирает структуру запроса и ответа: метод, URI, заголовки, тело. Это позволяет применять правила на основе содержимого: блокировать запросы по URL-шаблонам, удалять или добавлять заголовки, проверять тип контента по MIME-типу, перенаправлять на основе User-Agent. Примеры — Squid в HTTP-режиме, mitmproxy, прокси-модуль Nginx. L7-прокси способен работать в режиме MITM (man-in-the-middle) для HTTPS-трафика, но только при наличии доверенного корневого сертификата на клиентском устройстве. В этом случае прокси генерирует поддельный сертификат для целевого домена, устанавливает два TLS-соединения — клиент–прокси и прокси–сервер — и получает доступ к расшифрованному содержимому. Это требует явного развёртывания инфраструктуры доверия и применяется только в управляемых средах.

По степени анонимности

Прозрачный прокси (transparent proxy) не требует настройки на клиентской стороне — перехват трафика осуществляется на уровне маршрутизации или перенаправления пакетов (например, через iptables REDIRECT). Клиент не знает о присутствии прокси. В ответах или логах сервера могут сохраняться исходные клиентские метаданные: заголовок X-Forwarded-For содержит IP клиента, Remote-Addr в логах прокси — тоже. Такой режим часто используется для кэширования или фильтрации в провайдерских сетях.

Анонимный прокси (anonymous proxy) скрывает исходный IP-адрес клиента, но явно указывает факт проксирования. Сервер получает запрос от прокси и видит, что соединение прошло через посредника — например, по наличию заголовка Via или Proxy-Connection. Исходный адрес в X-Forwarded-For отсутствует или заменён на обобщённое значение.

Прокси высокой анонимности (elite proxy, high anonymity proxy) имитирует прямое соединение. Он не добавляет специфических заголовков, не передаёт исходный IP-адрес, не оставляет признаков проксирования в метаданных. Сервер воспринимает запрос так, будто он поступил напрямую от прокси-узла. Такая конфигурация достигается строгим контролем исходящих заголовков и отключением диагностических полей.

Протоколы и стандарты

Работа прокси-серверов базируется на стандартизированных протоколах, определяющих формат запросов, методы установки соединений и расширения для аутентификации и маршрутизации. Эти протоколы обеспечивают совместимость между клиентами, прокси и серверами, независимо от производителя или операционной системы.

HTTP-прокси (RFC 7230–7235 и сопутствующие спецификации)

HTTP-прокси реализует посредничество на прикладном уровне с использованием протокола HTTP/1.1. Клиент формирует запрос так, будто обращается к прокси напрямую, но в строке запроса указывает полный URI целевого ресурса — в отличие от прямого соединения, где используется только путь.

Пример прямого HTTP-запроса к серверу example.com:

GET /index.html HTTP/1.1

Host: example.com

Тот же запрос через HTTP-прокси:

GET http://example.com/index.html HTTP/1.1

Host: example.com

Прокси извлекает схему, хост и порт из URI, устанавливает соединение с целевым сервером и пересылает запрос, удаляя схему из строки метода — сервер получает запрос в исходном формате.

Для работы с зашифрованным трафиком (HTTPS) используется метод CONNECT. Клиент посылает команду вида:

CONNECT example.com:443 HTTP/1.1

Host: example.com:443

Прокси устанавливает TCP-соединение с указанным хостом и портом, после чего переводит соединение в режим «туннелирования»: все последующие байты от клиента пересылаются серверу без изменений, и наоборот. В этом режиме прокси не имеет доступа к содержимому передаваемых данных — шифрование TLS остаётся сквозным между клиентом и сервером.

Расширения протокола HTTP позволяют управлять взаимодействием с прокси:

- Заголовок

Proxy-Authorizationпередаёт учётные данные для аутентификации на прокси. Обычно применяется схема Basic или Digest. Сервер прокси отвечает кодом407 Proxy Authentication Required, если аутентификация не пройдена. - Заголовок

Proxy-Connection— устаревшее расширение, использовавшееся в ранних реализациях для управления keep-alive на уровне прокси. В HTTP/1.1 заменено семантикойConnection: keep-alive, которая распространяется на весь цепочку соединений. - Заголовки

ViaиForwarded(RFC 7239) используются для передачи информации о прохождении запроса через промежуточные узлы.Viaуказывает версию протокола и имя хоста прокси.Forwarded— более структурированная альтернатива, позволяющая передавать IP-адрес клиента, протокол, хост и порт в едином поле.

HTTP-прокси полностью совместим с веб-браузерами, утилитами командной строки (curl, wget) и большинством HTTP-клиентских библиотек. Поддержка не требует специальных драйверов или перехвата сетевого стека.

Протокол SOCKS (RFC 1928, RFC 1929)

SOCKS — независимый от прикладного протокола механизм проксирования на транспортном уровне. Он работает с TCP и, начиная с версии 5, с UDP. Клиент устанавливает TCP-соединение с SOCKS-сервером и посылает управляющее сообщение, содержащее тип запроса (установка соединения или привязка порта), адрес назначения и порт. После подтверждения сервера соединение переходит в режим прозрачной пересылки байтов.

SOCKS4 поддерживает только TCP и IPv4. В запросе передаётся 4-байтовый IP-адрес и 2-байтовый номер порта. Аутентификация отсутствует — клиент идентифицируется только по IP-адресу соединения. Для передачи доменных имён применяется нестандартное расширение SOCKS4a: вместо IP-адреса передаётся нулевой октет, затем доменное имя в виде строки, завершённой нулём.

SOCKS5 (RFC 1928) представляет собой значительное расширение:

- Поддержка IPv6 — адрес может быть представлен 16-байтовым IPv6, 4-байтовым IPv4 или строкой доменного имени.

- Поддержка UDP-ассоциированных соединений (UDP ASSOCIATE) — клиент получает порт на прокси, на который может отправлять UDP-пакеты; прокси пересылает их целевому узлу и возвращает ответы.

- Гибкая аутентификация (RFC 1929): клиент и сервер договариваются о методе аутентификации в начальном handshake. Поддерживаются:

0x00— без аутентификации;0x02— аутентификация по логину и паролю (передаются в открытом виде);0x01— GSS-API (например, Kerberos);- Расширяемость через IANA-регистрацию методов.

SOCKS5 не зависит от прикладного протокола: поверх него могут работать SSH, SMTP, FTP, игры, VoIP. Клиентская поддержка встроена в большинство операционных систем (через настройки сети или API SOCKS в сокетах), а также в приложения вроде PuTTY, cURL (--socks5), Tor Browser.

WPAD — Web Proxy Auto-Discovery Protocol (IETF Draft, фактический стандарт)

WPAD упрощает развёртывание прокси в крупных сетях, позволяя клиентам автоматически обнаруживать конфигурацию прокси без ручного ввода адреса и порта. Механизм основан на двух методах обнаружения: через DHCP и через DNS.

При использовании DHCP клиент включает опцию 252 (WPAD) в запрос на получение IP-адреса. Сервер DHCP отвечает, указывая URL файла конфигурации прокси (обычно http://wpad.example.com/wpad.dat).

При использовании DNS клиент выполняет поиск записи wpad в текущем домене и его родительских зонах (например, wpad.corp.example.com, затем wpad.example.com, затем wpad.com). Если найдена A- или AAAA-запись, клиент запрашивает по HTTP файл wpad.dat с этого хоста.

Файл wpad.dat — это JavaScript-функция FindProxyForURL(url, host), возвращающая строку вида:

"DIRECT" // прямое соединение

"PROXY proxy1:3128" // через HTTP-прокси

"SOCKS socks1:1080" // через SOCKS-прокси

"PROXY proxy1:3128; PROXY proxy2:3128" // резервирование

Функция может использовать встроенные вспомогательные функции: isInNet(), dnsDomainIs(), shExpMatch() — для принятия решений на основе IP-диапазонов, доменов или шаблонов. WPAD применяется в корпоративных сетях Microsoft (через групповые политики), в крупных университетах, провайдерах. Безопасность WPAD критически зависит от контроля над DHCP- и DNS-инфраструктурой: подмена wpad.dat позволяет перенаправить весь трафик через злоумышленника.

Проксирование HTTPS: особенности и ограничения

HTTPS-трафик по умолчанию не поддаётся инспекции на уровне L7, так как содержимое защищено TLS. Прокси может выступать в двух режимах:

-

Туннелирование через

CONNECT— стандартный, безопасный режим. Прокси устанавливает TCP-соединение, но не имеет доступа к расшифрованным данным. Сертификат проверяется клиентом напрямую с целевым сервером. Никаких дополнительных доверительных отношений не требуется. -

MITM-инспекция (man-in-the-middle) — расширенный режим, применяемый в корпоративной безопасности. Прокси генерирует динамический сертификат для целевого домена, подписанный локальным центром сертификации, развёрнутым в домене. Клиентское устройство должно доверять этому корневому сертификату — он устанавливается через групповые политики, MDM или вручную. После этого клиент принимает поддельный сертификат как валидный, и прокси получает возможность расшифровать, проанализировать и повторно зашифровать трафик. Такой подход применяется в решениях вроде Zscaler, Blue Coat, Squid с модулем

ssl_bump. Требуется строгий контроль за жизненным циклом сертификатов, исключение чувствительных доменов (банки, госуслуги) из инспекции, аудит операций.

Использование MITM-инспекции влечёт дополнительные требования к защите приватного ключа CA, к защите журналов расшифрованных сессий и к информированию пользователей в соответствии с законодательством о персональных данных.

Функциональные возможности

Прокси-серверы реализуют широкий набор функций, выходящих за рамки простой пересылки данных. Эти функции формируют основу для построения управляемых, безопасных и эффективных сетевых сред. Каждая функция опирается на конкретные алгоритмы, протоколы и конфигурационные параметры, позволяя адаптировать поведение прокси под требования бизнеса, безопасности и производительности.

Кэширование

Кэширование — механизм локального хранения копий ранее полученных ответов с целью повторного использования без обращения к исходному серверу. Прокси сохраняет ответы в соответствии с правилами, заданными в заголовках Cache-Control, Expires, ETag, Last-Modified, а также в соответствии с локальной политикой (размер кэша, приоритеты доменов, исключения).

Эффективность кэширования измеряется коэффициентом hit-отношения (hit ratio) — долей запросов, удовлетворённых из кэша. В корпоративных сетях при работе с CDN-контентом, ПО-репозиториями (npm, PyPI, Docker Hub), обновлениями ОС и офисными приложениями hit ratio часто превышает 60–80 %. Это приводит к снижению задержек для пользователей, уменьшению потребления внешнего канала и снижению нагрузки на внешние серверы.

Пример: в крупной организации с 500 сотрудниками каждый из которых ежедневно загружает один и тот же пакет обновлений весом 200 МБ, прокси сохраняет его один раз и раздаёт остальным локально. Внешний трафик уменьшается с 100 ГБ до 200 МБ.

Системы кэширования применяют стратегии замещения: LRU (least recently used), LFU (least frequently used), адаптивные алгоритмы на основе частоты запросов и размера объекта. Squid, Nginx (proxy_cache), Varnish предоставляют детальный контроль над временем хранения, вариациями по заголовкам (Vary), валидацией через If-None-Match, фоновой регенерацией (stale-while-revalidate).

Кэш может быть иерархическим: локальный прокси направляет промахи в родительский кэш (parent cache), образуя древовидную топологию — это распространено в провайдерских сетях и государственных инфраструктурах.

Фильтрация контента

Фильтрация — применение политик доступа к сетевым ресурсам на основе анализа запроса, ответа или метаданных соединения. Фильтрация работает на нескольких уровнях:

- URL-фильтрация — сопоставление URI с белыми и чёрными списками, регулярными выражениями, категориями (социальные сети, игры, порнография). Базы категорий поддерживаются коммерческими поставщиками (Kaspersky Security for Internet Gateway, Cisco Umbrella) или формируются вручную.

- MIME-фильтрация — блокировка по типу контента, определённому по заголовку

Content-Typeили по сигнатуре (magic numbers) в теле ответа. Например, запрет наapplication/x-msdownload,application/octet-streamв корпоративной среде снижает риски запуска вредоносных исполняемых файлов. - Сигнатурная фильтрация — интеграция с антивирусными движками через протокол ICAP (Internet Content Adaptation Protocol, RFC 3507). Прокси передаёт тело ответа на анализ (REQMOD — модификация запроса, RESPMOD — модификация ответа), получает вердикт (разрешить, заблокировать, карантин) и применяет действие. Пример: Squid + ClamAV или Kaspersky ICAP Server.

- Контекстная фильтрация — учёт времени суток, группы пользователя, устройства, геолокации (по IP). Политика может разрешать доступ к обучающим ресурсам в рабочее время для сотрудников отдела R&D, но блокировать те же ресурсы в нерабочее время для всех остальных.

Фильтрация применяется не только для блокировки, но и для трансформации: замена страницы блокировки на информационное сообщение, перенаправление на портал аутентификации, инъекция баннеров с предупреждениями.

Аудит и логирование

Аудит — фиксация событий взаимодействия для последующего анализа, расследования и отчётности. Прокси генерирует логи на каждом этапе обработки запроса: приёма, аутентификации, маршрутизации, кэширования, фильтрации, передачи серверу, получения ответа.

Стандартный формат лога включает:

- временную метку,

- IP-адрес клиента,

- имя пользователя (если аутентифицирован),

- метод и полный URI запроса,

- код ответа,

- размер переданного тела,

- время обработки (TTLB — time to last byte),

- имя upstream-сервера,

- кэш-статус (HIT, MISS, REFRESH),

- применённые политики фильтрации.

Логи агрегируются в централизованные системы (ELK-стек, Graylog, Splunk), где строятся дашборды: топ запрашиваемых доменов, динамика трафика по категориям, аномалии в поведении (резкий рост запросов к одному хосту), выявление утечек данных (передача больших объёмов на внешние ресурсы).

Аудит поддерживает соответствие требованиям регуляторов: в соответствии с ФЗ-152 «О персональных данных» и рекомендациями ФСТЭК, логирование действий с доступом к информационным системам, обрабатывающим персональные данные, является обязательным элементом защиты.

Аутентификация

Аутентификация — подтверждение личности пользователя перед предоставлением доступа через прокси. Прокси интегрируется с корпоративными системами идентификации, обеспечивая единый вход без дублирования учётных записей.

Основные методы:

- Базовая и дайджест-аутентификация по HTTP — простые механизмы, встроенные в протокол. Передача учётных данных в заголовке

Proxy-Authorization. Подходит для изолированных сред, но не рекомендуется без TLS. - Интеграция с Active Directory через Kerberos/Negotiate — клиент (браузеры, ОС Windows) автоматически передаёт билет Kerberos в заголовке

Proxy-Authorization: Negotiate …. Прокси (например, Squid с GSSAPI) проверяет билет у контроллера домена. Пользователь не вводит пароль — используется сессия ОС. - LDAP-привязка — прокси выполняет поиск и bind к LDAP-серверу (OpenLDAP, AD в режиме LDAP) по логину и паролю. Гибкость в выборе атрибутов, поддержка вложенных групп.

- RADIUS — применяется в гетерогенных средах, особенно при интеграции с сетевым оборудованием (точки доступа, шлюзы). Прокси выступает RADIUS-клиентом, передавая учётные данные на сервер (FreeRADIUS, Cisco ISE).

- Токены и SSO — поддержка заголовков

Authorization: Bearer …для OAuth2/JWT, интеграция с IdP (Keycloak, Auth0) через OpenID Connect.

Аутентификация позволяет строить политики на основе групповой принадлежности: «разрешить доступ к GitHub только для группы Developers», «ограничить скорость для группы Interns».

Трансформация трафика

Трансформация — модификация структуры или содержимого запросов и ответов в процессе проксирования. Это позволяет адаптировать трафик под требования внутренних систем, улучшить совместимость или внедрить дополнительные данные.

Типичные операции:

- Перезапись заголовков — замена

X-Forwarded-Forна реальный IP клиента, добавлениеX-Real-IP,X-Request-IDдля сквозной трассировки, удалениеServer,X-Powered-Byв целях маскировки стека. - Сжатие и распаковка — прокси может сжимать ответы (

gzip,br) перед отправкой клиенту, даже если upstream-сервер этого не делает; или, наоборот, распаковывать для анализа содержимого при MITM-инспекции. - Инъекция метрик и трассировки — добавление заголовков

Traceparent(W3C Trace Context),Correlation-ID, меток времени, имени узла — для интеграции с системами APM (Application Performance Monitoring). - Переписывание URI — изменение пути или параметров запроса. Пример: перенаправление устаревшего API-пути

/v1/usersна/api/v2/usersбез изменения клиентского кода. - Модификация тела — в L7-прокси с поддержкой скриптов (Nginx + njs, mitmproxy + Python) возможно изменение HTML (инъекция скриптов, изменение ссылок), JSON (фильтрация полей), или бинарных данных (патчинг).

Трансформация применяется в сценариях миграции, A/B-тестирования, канареечных развёртываний, внедрения клиентских метрик.

Примеры развёртывания

Прокси-серверы редко функционируют как изолированные компоненты. Их ценность проявляется в интеграции с другими элементами инфраструктуры: системами аутентификации, антивирусными движками, балансировщиками нагрузки, мониторингом. Рассмотрим четыре распространённых сценария развёртывания — от корпоративной защиты до отладки и глобальной доставки контента.

Корпоративный прокси-шлюз

Корпоративный прокси-шлюз обеспечивает централизованный контроль исходящего интернет-трафика для всех пользователей организации. Типовая архитектура включает:

- Прокси-движок — Squid, наиболее распространённое решение для L7-проксирования в Linux-средах. Обрабатывает HTTP/HTTPS, поддерживает кэширование, ACL, интеграцию с внешними сервисами.

- Аутентификация через Kerberos — Squid скомпилирован с поддержкой

--enable-auth-negotiateи модулемnegotiate_kerberos_auth. При первом запросе клиент (браузер в домене Windows) автоматически передаёт SPNEGO-токен. Squid проверяет его у контроллера домена через GSS-API. Пользователь не вводит пароль — используется сессия операционной системы. - Фильтрация через ICAP — Squid настраивается на отправку тела ответа в RESPMOD-режиме на ICAP-сервер. В качестве ICAP-сервера выступает:

- ClamAV — для антивирусной проверки;

- Kaspersky Security for Internet Gateway — для комплексной фильтрации (вирусы, фишинг, категории, DLP);

- собственный сервис на основе YARA или Sigma-правил — для поиска сигнатур утечек.

- Кэширование с иерархией — локальный Squid направляет промахи в региональный кэш (parent cache), а тот — в центральный. Используется протокол ICP (ICPv2) или HTCP для координации.

- Логирование и аудит — логи Squid передаются в syslog-ng → Kafka → ClickHouse; построены отчёты по топ-10 запрашиваемых доменов, динамике трафика, событиям блокировки.

Такая система обеспечивает соответствие требованиям информационной безопасности: контроль доступа, анализ содержимого, регистрация событий, защита от вредоносного ПО. Она масштабируется горизонтально — через балансировщик (HAProxy) перед пулом Squid-узлов.

Разработка и отладка

В процессе разработки и тестирования ПО прокси-серверы применяются для перехвата, анализа и модификации сетевого взаимодействия. Основные инструменты — mitmproxy и Fiddler — реализуют интерактивное L7-проксирование с возможностью программного расширения.

mitmproxy работает в режиме MITM: клиент настраивается на прокси, устанавливается корневой сертификат mitmproxy CA. Все HTTPS-соединения расшифровываются, отображаются в консоли или веб-интерфейсе (mitmweb). Возможности:

- просмотр структуры запроса и ответа (заголовки, тело, cookies);

- модификация в реальном времени — изменение параметров, подмена JSON-полей, задержка ответа (для тестирования таймаутов);

- запись сессий в HAR-файл для последующего анализа;

- написание скриптов на Python (

@request,@response) для автоматической трансформации (например, добавление заголовкаX-Debug: trueдля всех запросов к/api/*).

Fiddler (Windows, .NET-стек) предоставляет аналогичный функционал с упором на интеграцию с Visual Studio, поддержку WebSocket, Composer для формирования запросов, AutoResponder для мокирования.

Такие инструменты применяются:

- бэкенд-разработчиками — для проверки корректности API-ответов;

- фронтенд-разработчиками — для мокирования бэкенда до его готовности;

- QA-инженерами — для имитации ошибок (5xx, таймауты), проверки обработки edge cases;

- специалистами по безопасности — для поиска уязвимостей (инъекции, утечки заголовков).

Использование ограничено доверенной средой — только на машинах разработчиков, в изолированных тестовых сетях. Распространение корневого сертификата за пределы таких сред недопустимо.

Обратный прокси для веб-приложений

Обратный прокси размещается перед пулом серверов приложения и обеспечивает терминацию клиентских соединений, балансировку, защиту и ускорение. Nginx — наиболее распространённая реализация в этой роли.

Типовая конфигурация:

- Терминация TLS — Nginx загружает сертификат и приватный ключ, обрабатывает handshake, расшифровывает трафик. Внутренние серверы получают HTTP-трафик без шифрования (в доверенной зоне), что снижает их нагрузку.

- Балансировка нагрузки — методы:

round-robin— поочерёдное распределение;least_conn— направление на сервер с наименьшим числом активных соединений;ip_hash— фиксация клиента к одному серверу по хешу IP (для сессий без кластеризации);hash $request_uri consistent— для кэширования на уровне приложения.

- Ограничение частоты (rate limiting) — на основе

limit_req_zoneпо IP или$binary_remote_addr. Пример: 100 запросов в секунду с одного IP, с burst-буфером в 20. Превышение — ответ503. - Сжатие —

gzip on,gzip_types application/json text/css— сокращение объёма передаваемых данных на 60–80 % для текстовых форматов. - Кэширование статики —

proxy_cacheс разделением по зонам, TTL,VaryпоAccept-Encoding. Часто кэшируются CSS, JS, изображения, шрифты. - Мониторинг состояния —

health_checkс интервалом и порогами; исключение сервера при трёх неудачных проверках.

Nginx интегрируется с системами оркестрации: в Kubernetes он выступает как Ingress Controller, в Docker Swarm — как внешний балансировщик. Конфигурация управляется через шаблоны (Jinja2, Helm), CI/CD-конвейеры, API (Nginx Plus).

Интеграция с CDN

Глобальные CDN (Cloudflare, Fastly, Akamai, Яндекс.Кэш) используют прокси-архитектуру на границе сети (edge) — каждый PoP (point of presence) функционирует как распределённый прокси-узел.

Поток данных при запросе к example.com, защищённому CDN:

- Клиент запрашивает

example.com→ DNS возвращает IP ближайшего edge-узла. - Edge-узел устанавливает TLS-соединение с клиентом (терминация на границе).

- Проверяется кэш: если объект свежий — отдаётся напрямую.

- При промахе edge-узел выступает как forward-прокси для origin-сервера (

origin.example.com), запрашивая ресурс по внутреннему протоколу (часто HTTP/2 или QUIC). - Перед передачей клиенту применяются трансформации: минификация HTML/CSS/JS, конвертация изображений в WebP/AVIF, адаптация под устройство (

Save-Data,Viewport-Width). - Параллельно работает WAF (Web Application Firewall): анализ заголовков, тела, частоты — блокировка SQLi, XSS, path traversal.

- При атаке типа L7 DDoS включаются механизмы rate limiting, challenge (CAPTCHA, JS-челлендж), greylisting.

CDN-прокси обеспечивают:

- снижение latency за счёт географической близости;

- защиту origin-сервера — он получает только легитимный, предварительно отфильтрованный трафик;

- ускорение за счёт оптимизаций транспорта (HTTP/3, BBR, early hints);

- отказоустойчивость — при недоступности origin используется stale-контент (

stale-while-revalidate,stale-if-error).

Конфигурация CDN управляется через панель или API: правила маршрутизации, кэширования, WAF, Workers (серверless-логика на edge, например, Cloudflare Workers на JavaScript/V8).

Безопасность и ограничения

Прокси-серверы предоставляют мощные инструменты управления трафиком, однако их применение сопряжено с объективными ограничениями и рисками, требующими учёта при проектировании архитектуры.

Риски MITM-инспекции HTTPS

MITM-инспекция требует развёртывания локального центра сертификации и установки его корневого сертификата на все клиентские устройства. Это создаёт дополнительную поверхность атаки: компрометация приватного ключа CA позволяет злоумышленнику подделывать сертификаты для любых доменов в рамках инфраструктуры. Требуются меры:

- хранение ключа CA на аппаратном модуле безопасности (HSM);

- строгий контроль доступа к CA-серверу;

- аудит всех выданных сертификатов;

- исключение из инспекции доменов, обрабатывающих высокочувствительные данные (например,

gosuslugi.ru,sbrf.ru,alfabank.ruпо рекомендациям Банка России).

Утечка метаданных

Даже при полном шифровании тела запроса и ответа (TLS 1.3 с perfect forward secrecy) сохраняются метаданные, доступные на уровне прокси и сетевого оборудования:

- доменное имя в SNI (Server Name Indication) — раскрывается в открытом виде при установке TLS-соединения;

- IP-адрес и порт целевого сервера;

- объём переданных данных (в байтах);

- временные метки начала и окончания соединения;

- частота и периодичность запросов.

Эти данные позволяют строить профили поведения: определить, пользуется ли пользователь мессенджером, посещает ли медицинские или финансовые ресурсы, работает ли по расписанию. Для снижения рисков применяются:

- использование DNS-over-HTTPS (DoH) или DNS-over-TLS (DoT) — скрытие DNS-запросов;

- включение TLS 1.3 с ESNI/ECH (Encrypted Client Hello) — шифрование SNI (на стадии развёртывания в браузерах и CDN);

- ограничение логирования — хранение IP только в течение времени, необходимого для расследования инцидентов;

- агрегация и анонимизация логов для аналитики.

Open relay и неправильные ACL

Некорректная конфигурация правил доступа (ACL — access control lists) может превратить прокси в open relay — узел, принимающий соединения от любых клиентов и направляющий их на любые серверы. Это используется для рассылки спама, сканирования уязвимостей, анонимных атак. Защита строится на принципе «запрещено всё, кроме явно разрешённого»:

- явное указание разрешённых источников (сети, IP, группы);

- явное указание разрешённых назначений (домены, IP-диапазоны, порты);

- запрет метода

CONNECTна порты, кроме 443 и 563; - регулярная проверка конфигурации с помощью сканеров (например,

nmap --script http-open-proxy).

Отсутствие сквозного шифрования

Прокси, даже в режиме туннелирования CONNECT, не обеспечивает сквозное шифрование в полном смысле: TLS-соединение завершается на прокси при MITM или на клиенте при стандартном CONNECT. Для достижения end-to-end encryption необходимо дополнительное шифрование на прикладном уровне — например:

- использование

pgpилиageдля шифрования вложений в почте; - применение

Signal Protocolв мессенджерах; - передача данных через HTTPS с клиентской проверкой сертификата (certificate pinning).

Прокси остаётся точкой, где трафик может быть доступен в открытом виде — либо технически (при инспекции), либо юридически (по запросу регулятора). Это свойство учитывается при проектировании систем, обрабатывающих персональные данные, государственную тайну или коммерческую тайну.

Правовой аспект

Использование прокси-технологий в составе корпоративной инфраструктуры допустимо при соблюдении требований законодательства Российской Федерации в части обработки персональных данных (Федеральный закон № 152-ФЗ), обеспечения информационной безопасности (требования ФСТЭК России, ФСБ России) и защиты прав субъектов персональных данных.

Организация обязана:

- уведомлять пользователей о применении прокси-серверов в политике обработки персональных данных;

- получать согласие на обработку данных, включая логирование, если это требуется по целям обработки;

- обеспечивать защиту логов в соответствии с категорией персональных данных (ПДн-1, ПДн-2);

- проводить оценку соответствия при обработке биометрических данных или данных о состоянии здоровья.

Распространение конфигураций прокси, предназначенных для обхода ограничений доступа к информационным ресурсам, подпадает под действие статьи 13.41 Кодекса Российской Федерации об административных правонарушениях. Ответственность наступает за предоставление средств для обхода блокировок, установленных на основании решений суда или Роскомнадзора.

Использование прокси в исследовательских, образовательных и профессиональных целях — например, для изучения сетевых протоколов, отладки приложений, обеспечения отказоустойчивости — не противоречит законодательству при условии соблюдения прав третьих лиц и ограничений, установленных владельцами ресурсов.